De AI Act is in werking getreden: dit moet je nu doen

Per 1 augustus 2024 is de AI Act in werking. Deze Europese wet regelt welke AI je onder welke voorwaarden mag toepassen. Nu is het moment daar om de AI Act toe te passen en compliant te worden. De AI Act treedt in fases in werking en in een serie van 3 artikelen kijken we naar wat je per fase moet doen. Dit is het eerste artikel en het gaat in op fase 1 die je vóór 1 februari 2025 moet afronden. Lees dus snel verder en ga aan de slag.

De AI Act

Een eerder artikel op Frankwatching beschrijft de AI Act uitgebreid. Hier kijken we nog even kort naar wat de AI Act is en hoe die werkt.

De AI Act is een Europese wet die Europese burgers beschermt tegen nadelige gevolgen van AI. Want men kan AI ook met verkeerde bedoelingen inzetten om bijvoorbeeld mensen met bepaalde gezichtskenmerken uit een groep te selecteren. Of om mensen te manipuleren, zoals bij verkiezingen of in het publieke debat.

Met de AI Act wil de EU haar burgers tegen dit soort praktijken beschermen. De AI Act doet dit door AI in risicocategorieën te verdelen en door per categorie via bepalingen en verplichtingen aan te geven welke AI is toegestaan of verboden en waar makers en gebruikers van de toegestane AI aan moeten voldoen.

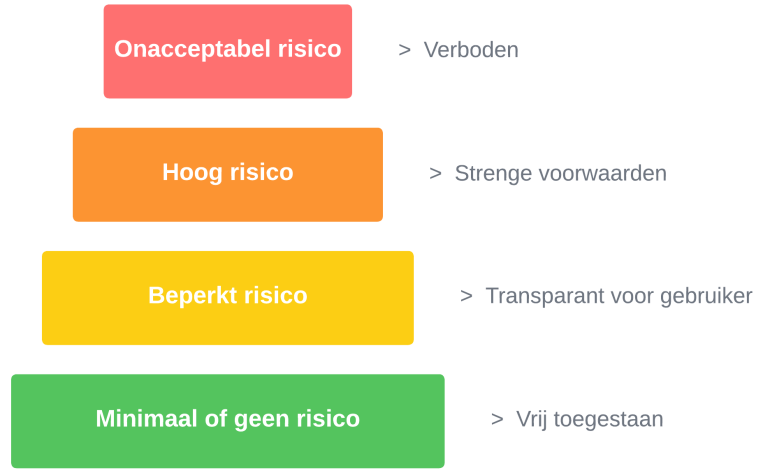

De risicocategorieën volgens de AI Act

De AI Act onderscheidt deze 4 AI-categorieën op basis van de mate van risico die ze voor burgers vormen:

AI met een onacceptabel risico:

Deze categorie van AI is en directe bedreiging voor burgers en daarom volgens de AI Act verboden. Een voorbeeld van deze categorie is social scoring op basis van de persoonlijke financiële situatie van burgers.

AI met een hoog risico:

Deze categorie bestaat uit AI die de rechten, gezondheid of veiligheid van burgers kan schaden. De AI Act staat gebruik van deze AI alleen onder strenge voorwaarden toe. De belangrijkste voorwaarde is dat mensen erop toezien dat deze AI geen burgers schaadt. AI die de achtergrond van sollicitanten screent, is een voorbeeld van de hoog risico-categorie.

AI met een beperkt risico:

Tot deze categorie behoort AI die burgers kan misleiden. Bijvoorbeeld door zich als een mens voor te doen. De AI Act staat deze categorie toe onder voorwaarde dat voor de gebruikers altijd duidelijk is dat ze met AI te maken hebben en op welke gegevens de AI zich baseert. Chatbots zijn een voorbeeld van AI met een beperkt risico.

AI met minimaal risico:

De rest van de AI vormt geen of een minimaal risico voor burgers en de AI Act staat deze categorie zonder beperkingen toe. Een spamfilter in een e-mailprogramma is een voorbeeld van AI met een minimaal risico.

De uitvoering van de AI Act

De AI Act is zoals iedere wet bij de invoering vooral een theoretische kader dat in de praktijk nog moet gaan leven en invulling moet krijgen. Deels zal dat gebeuren via voortschrijdende ervaring en inzicht vanuit de dagelijkse praktijk en deels via aanvullende wetgeving en rechterlijke uitspraken (jurisprudentie). Daarom zal de EU de AI Act eerst enigszins soepel handhaven en gaandeweg de regels strikter toepassen.

Als ondersteuning bij het toepassen van de AI Act gaat de EU een database met AI met een hoog risico aanleggen die (potentiële) gebruikers kunnen raadplegen.

De handhaving van de AI Act zal via audits gaan. Daarbij werkt de AI Act met een boetestelsel voor als je je niet aan de bepalingen houdt. Afhankelijk van de categorie die je overtreedt en de grootte van je organisatie, kan de boete per overtreding oplopen tot 35 miljoen euro of 7 procent van je jaaromzet.

Waar past general purpose AI in de AI Act?

Vlak nadat de EU het eerste concept van de AI Act klaar had, kwamen ChatGPT en andere general purpose AI plotseling opzetten. Ze bereikten in korte tijd miljoenen gebruikers die het voor een scala aan toepassingen (general purposes) gebruiken. Zo schrijft ChatGPT onder meer e-mails, maakt het projectplannen, schrijft het software, maar beoordeelt het ook cv’s of kredietaanvragen.

Het gebruik van ChatGPT bepaalt de risicocategorie

Deze variatie in toepassingen is echter een probleem voor de risicocategorie-opzet van de AI Act. Door de veelzijdigheid heeft ChatGPT geen eenduidig ingebouwd doel, zoals een spamfilter dat bijvoorbeeld wel heeft. Het doel van ChatGPT wisselt telkens af door wat je het laat doen. Dit heeft als gevolg dat de risicocategorie waarin ChatGPT valt ook wisselt en afhangt van wat je met ChatGPT doet.

Stel dat je ChatGPT een e-mail op schrijfstijl laat controleren, dan valt ChatGPT in de minimaal risicocategorie. Maar als je ChatGPT vervolgens cv’s laat beoordelen en afwijzen, dan valt ChatGPT ineens in de hoog risicocategorie.

De EU rekent general purpose AI tot de hoog risicocategorie

Om dit probleem met general purpose AI te ondervangen, rekent de EU dit type AI tot de hoog risicocategorie. We zullen in de praktijk moeten zien hoe dit via audits, handhaving en rechtspraak uitpakt. Op dit moment moet je ChatGPT als hoog risico beschouwen en volgens de bijbehorende bepalingen toepassen.

Aangevuld met de verplichting dat je altijd het auteursrecht respecteert, omdat ChatGPT op bestaande teksten en bronnen werkt en dat je een tekst labelt met de melding dat deze door ChatGPT gemaakt is.

Stappenplan om de AI Act toe te passen

Voor wat betreft het toepassen van de AI Act gaan we ervanuit dat je als Frankwatching-lezer vooral een gebruiker van AI bent. Als ethisch verantwoorde AI-gebruiker wil je natuurlijk compliant zijn. Dit stappenplan helpt je daarbij:

- Inventariseer alle AI die je gebruikt. Denk daarbij ook aan AI dat onderdeel is van software, bijvoorbeeld in een CMS-systeem.

- Bepaal per AI de risicocategorie. Gebruik hierbij de Europese database om te controleren op AI met een hoog risico. Vraag je leverancier van de AI of software met AI-onderdelen zo nodig om hulp bij het inschatten van de categorie.

- Leg op basis van de risicocategorie per AI vast hoe je het volgens de bepalingen van de AI Act gaat gebruiken. Hiermee documenteer je meteen hoe je de AI toepast en dat is belangrijk voor als je een audit krijgt.

- Pas per AI de in de voorgaande stap vastgestelde omgang toe.

Je uitvoering van het stappenplan hangt af van de grootte van je organisatie en de hoeveelheid AI die je gebruikt. Ben je een eenpitter of een mkb’er met enkele medewerkers? Dan voer je de stappen als een set taken uit. Werk je in een grote organisatie met meerdere afdelingen en teams? Dan is een projectmatige aanpak het beste. Als je organisatie een compliance-afdeling en compliance officer heeft, dan betrek je ze uiteraard bij het stappenplan of nemen zij het voortouw.

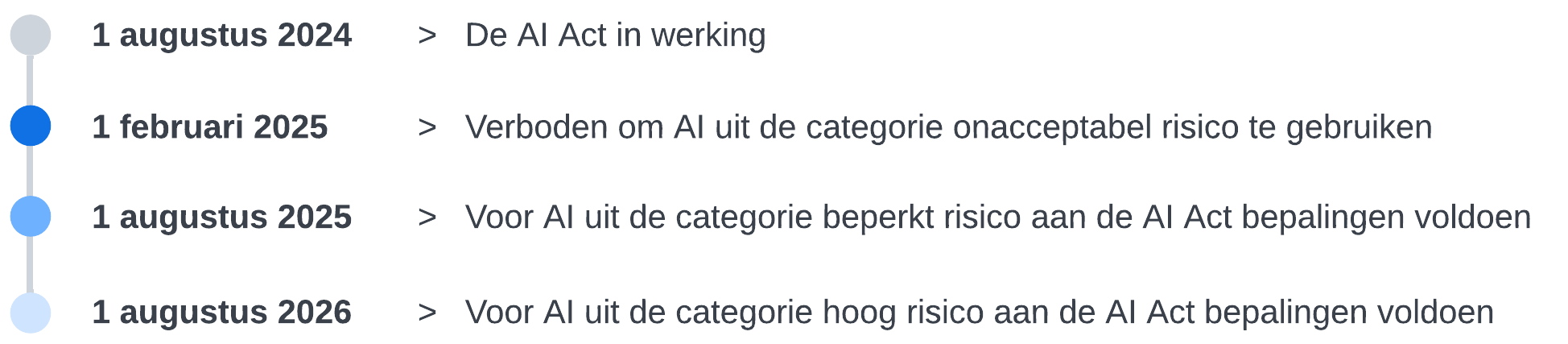

Fasering en tijdspad van de AI Act

Om AI-makers en -gebruikers de tijd te geven om compliant te worden, voert de EU de AI Act gefaseerd in volgens dit tijdspad:

Dit tijdsplan betekent dat je eerst de onacceptabele (verboden) AI moet uitfaseren als je die gebruikt. Verder heb je nog tot augustus 2025 de tijd om voor AI met een beperkt risico aan de AI Act te voldoen. Vervolgens moet je voor de AI met hoog risico per augustus 2026 compliant zijn.

De acties die je moet doen om aan de AI Act te voldoen, kunnen talrijk en omvangrijk zijn. Zo kan het nodig zijn om een bestaande AI-toepassing te vervangen, dus inclusief de invoering van de nieuwe AI en training van de gebruikers. Daarom is het belangrijk om de planning en uitvoering van je stappenplan op het tijdspad af te stemmen.

Zoals gezegd, is de eerste stap die je nu moet doen het uitfaseren van verboden AI. Daarom sluiten we dit artikel af met het kijken naar hoe je dit aan kunt pakken. In het tweede en derde artikel van deze serie over het toepassen van de AI Act, kijken we dan naar de resterende fases en risicocategorieën.

Uitfaseren van verboden AI

Neem voor het uitfaseren van verboden AI het stappenplan als uitgangspunt: inventariseer eerst alle AI die je gebruikt. Bepaal daarna aan de hand van de risicocategorieën en het onderstaande overzicht van verboden AI-toepassingen of je op dit moment verboden AI gebruikt. Als dat zo is, dan moet je deze AI vóór 1 februari 2025 uitfaseren.

Verboden AI-toepassingen

Volgens de AI Act zijn de volgende AI-toepassingen een bedreiging voor burgers en daarom verboden:

Van deze toepassingen zijn social scoring en manipuleren of misleiden het meest relevant voor marketing.

Voorbeeld van verboden AI en strategieën voor uitfaseren

Stel dat je bij de inventarisatie vaststelt dat je voor je marketing een AI-toepassing gebruikt die social scoring toepast en daardoor in de categorie verboden AI valt. Om deze AI uit te faseren, kun je een aantal strategieën volgen:

- De AI en de toepassing volledig stoppen: je kunt besluiten om helemaal te stoppen met de toepassing.

- De AI vervangen door een alternatieve toepassing: je kunt een alternatieve werkwijzen toe gaan passen om je doel te bereiken. Dus social scoring bijvoorbeeld vervangen door A/B testen.

- De AI vervangen door toegestane AI: ook kun je ervoor kiezen om AI te gebruiken die wel is toegestaan. Bijvoorbeeld AI die zich richt op geanonimiseerde groepen en alleen kenmerken van een groep benoemt. Zoals het kenmerk dat de groep die het meest in jouw dienst geïnteresseerd is, tussen de 45 en 55 jaar oud is en een eigen woning heeft. Je kunt dan je marketing op deze groep richten zonder dat je specifieke personen benadert of uitsluit.

- De AI vervangen door menselijk handelen: je kunt ook besluiten om te stoppen met AI, terwijl je de toepassing wel behoudt en die in het vervolg door mensen laat doen.

Neem deze stappen om verboden AI uit te faseren

Welke strategie je ook kiest, baseer je aanpak op het eerder besproken stappenplan en neem deze stappen:

- Kies met de betrokkenen in je organisatie de gewenste strategie voor het uitfaseren van de verboden AI.

- Als je voor alternatieve AI kiest, bepaal dan de risicocategorie van die AI.

- Maak per verboden AI een plan voor de uitvoering van de gekozen strategie.

- Optioneel: maak per alternatieve AI een plan voor de invoering en documenteer hoe je deze AI in het kader van de AI Act gaat toepassen.

- Faseer de verboden AI volgens je plannen uit.

- Optioneel: voer de gekozen alternatieven in en pas ze toe.

Als je alternatieven voor verboden AI invoert, dan voer je stap 5 en 6 telkens gezamenlijk uit.

Geen verboden AI meer

Zorg er hoe dan ook voor dat je ná 1 februari 2025 geen verboden AI meer gebruikt. Ook als je dan nog bezig bent met de invoering van een alternatief. Je wil geen boete, maar je wil ook zeker geen overtreder zijn. De pers zal daar ongetwijfeld uitgebreid over berichten en de imagoschade die je dan oploopt, is je ergste pr-nachtmerrie.

Lees hier deel 2: AI Act – fase 2: zorg dat je voor 1 augustus 2025 transparant bent