Wordt AI nooit slimmer dan mensen?

Gaan we in de toekomst machines uitvinden die zichzelf verbeteren, waardoor we geen controle meer hebben over de technologische groei? Dit omslagpunt wordt ook wel singulariteit genoemd. In dit stuk ga ik verder in wat hiermee bedoeld wordt én waarom we dit misschien nooit zullen bereiken.

Optimisme versus pessimisme

Er heerst zowel optimisme als pessimisme over kunstmatige intelligentie (AI) vandaag. De optimisten geloven dat AI de wereld een stap dichterbij een utopisch paradijs zal brengen. Daarbij kijken mensen in hun zetel toe hoe robots het zware werk doen. De pessimisten daarentegen voorspellen dat AI veel onheil met zich mee zal brengen: banenverlies, oorlogvoering en dergelijke.

Zowel de optimisten als de pessimisten doen vaak een beroep op de idee van een technologische singulariteit. Dat is een moment waarop machine-intelligentie begint te escaleren, en een nieuwe, intelligentere ‘soort’ ontstaat. Zowel de optimisten als de pessimisten zijn het erover eens dat dit moment de maatschappij fundamenteel zal veranderen. Het is daarom zeer de moeite waard om even stil te staan of één, of geen, van beide het bij het rechte eind heeft.

Het ontstaan van het begrip ‘singulariteit’

Het idee van een technologische singulariteit is terug te herleiden naar een aantal grote denkers in de vorige eeuw. In aansluiting op de dood van John von Neumann in 1957, schreef Stanislaw Ulam (Ulam, S, Tribute to John von Neumann):

Eén gesprek [met John von Neumann] ging over de steeds snellere vooruitgang van technologie en de veranderingen in de levenswijze van de mens, die de indruk geven dat deze evolutie naar één of andere kritische drempel, of singulariteit, toe evolueert die de toekomst van de mensheid op een fundamentele manier verandert.

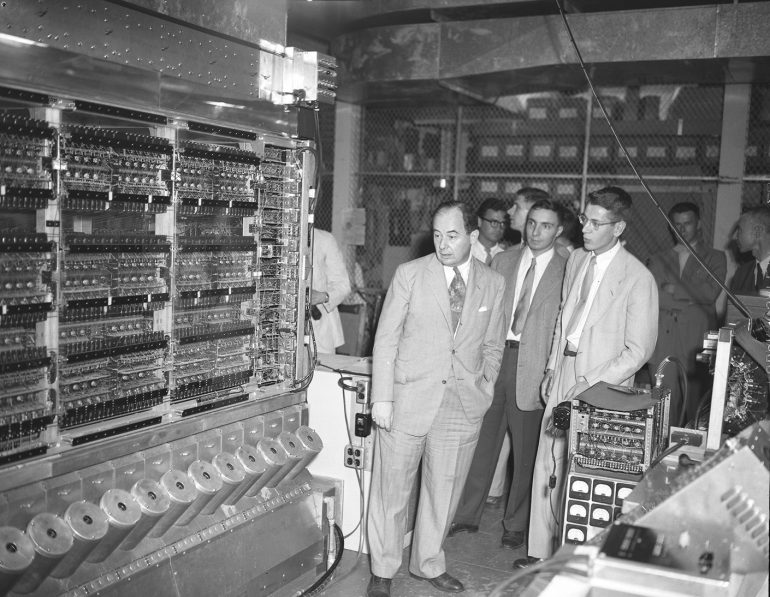

J. Von Neumann (vooraan) & R. Oppenheimer (rechts achter) (Credit: lan Richards photographer. Shelby White and Leon Levy Archives Center, Institute for Advanced Study, Princeton, NJ, USA )

I. J. Good deed een specifiekere voorspelling in 1965 (Good, Speculations Concerning the First Ultraintelligent Machine). Hij noemde het een ‘intelligentie-explosie’ in plaats van een ‘singulariteit’:

Laten we een ultra intelligente machine definiëren als een machine die alle intellectuele activiteiten van een mens kan overtreffen, hoe slim ook. Gezien het ontwerp van machines één van deze intellectuele activiteiten is, dan zou een ultra intelligente machine nog betere machines ontwerpen. Hieruit volgt ongetwijfeld een intelligentie-explosie die de intelligentie van de mens doet verbleken. Anders gezegd, de eerste superintelligente machine is ook de laatste die mens zal maken.

Recent is het idee van een technologische singulariteit populairder geworden door bijvoorbeeld Ray Kurzweil. Op basis van de huidige trends voorspelt Kurzweil (Kurzweil, When Humans Transcend Biology) de technologische singulariteit in 2045.

De term singulariteit

In dit artikel neem ik aan dat de technologische singulariteit het moment is in de tijd waarmee we een machine bouwen met voldoende intelligentie die zichzelf kan herontwerpen om haar intelligentie te verbeteren. Daarbij begint haar intelligentie exponentieel snel te groeien. Het overtreft iedere menselijke intelligentie.

Door deze mogelijkheid deden verschillende commentatoren akelige voorspellingen over de mogelijke impact van kunstmatige intelligentie op de mens. In december 2014 vertelde Stephen Hawking tijdens een interview op de BBC:

De ontwikkeling van volledige kunstmatige intelligentie zou het einde van het menselijk ras kunnen inluiden… Het zou starten met zichzelf te herontwerpen in een steeds toenemend tempo. Mensen, die worden beperkt door langzame biologische evolutie, zouden niet kunnen concurreren en worden vervangen.

Verschillende andere bekende figuren waaronder Bill Gates, Elon Musk en Steve Wozniak hebben daarna soortgelijke waarschuwingen gegeven. Bostrom heeft een technologische singulariteit voorspeld (Bostrom, Superintelligence: Paths, Dangers, Strategies), en stelde dat dit een existentiële bedreiging vormt voor de mensheid.

Waarom we ons geen zorgen hoeven te maken over de singulariteit

Het idee van een technologische singulariteit heeft meer aandacht gekregen buiten de reguliere AI-gemeenschap dan erin. Gedeeltelijk omdat veel van de voorstanders van zo’n concept zich buiten deze gemeenschap bevinden, en meer in de entertainment-sector. Denk maar aan de vele films en boeken gebaseerd op technologische doem-secnario’s zoals de Terminator-films.

De technologische singulariteit wordt ook enigszins geassocieerd met uitdagende ideeën zoals levensverlenging en transhumanisme. Dit is jammer omdat het ons afleidt van een fundamentelere en belangrijkere kwestie. Zullen we in staat zijn om machines te ontwikkelen die op een gegeven moment in staat zijn om hun intelligentie exponentieel snel te verbeteren en die onze menselijke intelligentie snel overtreft?

Dit lijkt op het eerste zicht geen bijzonder wild idee. Computers zijn aanzienlijk onderhevig aan exponentiële trends. De wet van Moore heeft, met grote nauwkeurigheid, voorspeld dat het aantal transistors op een geïntegreerd circuit (en dus de hoeveelheid geheugen in een chip) elke twee jaar verdubbelt sinds 1975. De wet van Koomey voorspelde dan weer dat het aantal berekeningen per joule van energie elke 19 maanden zal verdubbelen sinds de jaren 50.

Is het dan zo onredelijk om te veronderstellen dat dit ook zal gelden voor AI, en er een soortgelijke exponentiële groei zal plaats vinden?

Geen op hol geslagen groei

Laat ons wel wezen, ik beweer niet dat AI geen buitengewone intelligentie zal demonstreren. Want zoals velen werkzaam in het AI-veld, denk ik dat deze fase al begonnen is. Denk maar aan AI die in staat is om iedere schaakmeester uit te schakelen of nauwkeuriger dan radiologen CT-scans kan analyseren. In tussentijd zal AI een grote meerwaarde betekenen voor mens, maatschappij en economie op verschillende gebieden. Ik stel echter dat dit niet zal eindigen met een op hol geslagen exponentiële groei en daaruit volgende singulariteit.

Ik ben overigens niet de enige die sceptisch staat tegen over een bijna-goddelijke AI. Ook Alan Turing liet zich in 1963, in zijn Mind paper (Turing, Computers and Thought), kritisch uit hier tegenover. Onder meer omdat machines nooit bewust (zouden?) kunnen worden.

‘Leren leren’ moet je ook – leren

Intelligentie om een specifieke taak uit te voeren wordt vaak verward met het vermogen om met verbeterde intelligentie diezelfde taak uit te voeren. Dat is naar mijn mening één van de sterkste argumenten tegen het idee van een technologische singulariteit. David Chalmers schrijft in een analyse van het idee van een technologische singulariteit (Chalmers, The Singularity: A Philosophical Analysis):

Als we een AI produceren door machine learning, is het waarschijnlijk dat kort daarna we het leeralgoritme kunnen verbeteren en het leerproces uitbreiden, leidend tot AI+.

Hier is AI een systeem met intelligentie op menselijk niveau. AI+ is een systeem dat intelligenter is dan de intelligentste mens.

Maar waarom zouden we in staat zijn om kort daarna het leeralgoritme te verbeteren?

Vooruitgang is niet snel of makkelijk

Vooruitgang in machine learning-algoritmen was noch bijzonder snel, noch gemakkelijk. Denk maar aan de tientallen jaren dat het duurde om, nog steeds, relatief eenvoudige neurale netwerken te creëren. Deze neurale netwerken zijn nu in staat om tekst te lezen, beelden te herkennen en meer. Er is echter geen reden om aan te nemen dat dergelijke verder ontwikkelde neurale netwerken ook zelf hun onderliggende kernalgoritmes zullen kunnen aanpassen.

We ervaren momenteel een indrukwekkende vooruitgang in AI met behulp van deep learning. Dit heeft de stand van de techniek in spraakherkenning, computervisie, taalverwerking en een aantal andere domeinen aanzienlijk verbeterd. Deze verbeteringen zijn grotendeels te danken aan het gebruik van grotere datasets en diepere neurale netwerken.

Natuurlijk betekenen meer data en grotere neurale netwerken dat we meer rekenkracht nodig hebben. Een groot deel van deze rekenkracht wordt nu geleverd door GPU’s. Het beter kunnen herkennen van spraak of het identificeren van objecten heeft echter niet geleid tot een verbetering in deep learning zelf. De deep-learningalgoritmen zijn zelf niet verbeterd. Iedere verbetering aan de deep-learningalgoritmen zijn ontstaan door onze eigen intelligentie toe te passen op hun ontwerp.

Waar is AI die zichzelf beter leert leren?

We kunnen dit argument ook vanuit een andere richting bekijken. Kijk naar onszelf. Het is veel gemakkelijker voor ons om te leren hoe we een bepaalde taak beter kunnen doen, dan om te leren hoe we beter kunnen leren. Kijk naar welke specifieke taken diepe neurale netwerken nu al aan kunnen, zoals het verslaan van de beste Go-spelers. Dan is het vreemd dat er geen enkel voorbeeld is van AI die zichzelf spontaan beter leert leren. Er zijn systemen en algoritmes die andere AI-algoritmes aansturen en configureren. Maar ook deze leren niet verder dan de specifieke taak die hen werd toe bedeeld.

Er is dus mogelijk een fundamentele beperking die ons weerhoudt om AI echt zelflerend te maken. Totdat we deze beperking in kaart gebracht hebben, laat staan opgelost, kan van een singulariteit geen sprake zijn.

De wet van de ‘Verminderde Meerwaarde’ – Diminishing returns

Het idee van een technologische singulariteit veronderstelt doorgaans dat iedere generatie ontwikkelingen een fractie intelligenter zullen zijn dan de vorige. Maar mogelijk verminderen de prestatiewinsten in vergelijking met voorafgaande prestatiewinsten. In het begin is er immers vaak veel laaghangend fruit, maar daarna worden grotere verbeteringen alsmaar moeilijker. Een AI-systeem kan natuurlijk over ettelijke generaties verbeterd worden, maar dit betekent niet dat er geen bovengrens zit op de bereikbare intelligentie.

Stel, bijvoorbeeld, dat de verbetering die iedere generatie boekt de helft is van de vorige verbetering. Dan betekent dit dat het systeem nooit zijn initiële intelligentie zal kunnen verdubbelen. Of anders gezegd, als de prestatiewinsten, ten opzichte van elkaar, ook niet sterk toenemen, is een explosieve groei in intelligentie niet mogelijk.

Complexiteitsrem

Naast de limieten die volgen uit de algoritmiek zelf kan afnemend rendement ook afkomstig zijn van de moeilijkheid van het onderwerp waarop ze toegepast worden. Paul Allen, mede-oprichter van Microsoft, noemt dit de ‘complexiteitsrem’ (Allen, MIT Technology Review).

Naarmate we dieper en dieper gaan in ons begrip van natuurlijke systemen, merken we meestal dat we steeds meer gespecialiseerde kennis nodig hebben om ze ten gronde te begrijpen, en we ook gedwongen worden om onze wetenschappelijke theorieën voortdurend uit te breiden op steeds complexere manieren… wij geloven dat vooruitgang in de richting van het begrip [van cognitie] fundamenteel vertraagd wordt door deze complexiteitsrem.

Met andere woorden, ook al slagen we er toch in om AI-systemen op een exponentiële manier intelligenter te laten worden, dan nog is dit mogelijk niet voldoende. De complexiteit van de op te lossen vraagstukken stijgt mogelijk nog sneller.

Een voorbeeld van de complexiteitsrem is de explosieve groei in fundamentele vragen op gebied van theoretische fysica (Wat gebeurde er voor de oerknal?), en hoe het menselijk brein hier mogelijk al tegen zijn limieten aan loopt.

Onberekenbare problemen

Stel dat we toch exponentiële verbeteringen realiseren in AI. Dan nog zijn er vraagstukken die niet door deze AI kunnen worden opgelost. Dit noemen we NPC-problemen, een begrip uit de wiskundige informatica. Een voorbeeld van een NPC-probleem. Hoe stel je een optimaal werkrooster op voor verpleegkundigen in een ziekenhuis, dat rekening houdt met alle persoonlijke vragen van de medewerkers én wettelijke beperkingen? NPC-problemen zijn zo complex om te berekenen, dat ze zelfs voor super-AI’s onberekenbaar zijn.

Deze computationele complexiteit kan één van de fundamentele limieten zijn aangehaald in een vorig argument.

Tenzij we AI en machines ontwikkelen op een fundamenteel andere manier, zullen we waarschijnlijk tegen veel problemen aanlopen waarbij computationele complexiteit de prestaties beperkt.

Van superintelligentie verwachten we perfectie

In de praktijk gebruiken algoritmes een soort vuistregels, ook wel heuristieken genoemd, om dergelijke moeilijke problemen benaderend op te lossen. Oplossingen die door heuristieken worden gevonden zijn weliswaar nooit de perfecte oplossing. En van een superintelligentie verwachten we toch niets minder dan de perfectie, en geen benadering ervan?

Opnieuw betekent dit niet dat AI nu en in de nabije toekomst dergelijke problemen niet op een goede, en beter dan menselijk mogelijk, wijze kan oplossen. In dit stuk wil ik enkel het mogelijk bestaan van een almachtige singulariteit in de toekomst in vraag stellen.

Bovenmenselijke niveaus van intelligentie

Ik heb enkele denkpistes aangehaald waarom we misschien nooit getuige zullen zijn van een technologische singulariteit. Niettemin, zelfs zonder een technologische singulariteit, is het zeer waarschijnlijk dat machines bovenmenselijke niveaus van intelligentie zullen vertonen.

Als dit het geval is, zal de impact van AI op onze economie, en op onze samenleving, minder dramatisch zijn dan wat de pessimisten of de optimisten over de singulariteit hebben voorspeld, maar zeker niet minder waardevol.