Open je kluis met goud: in 3 stappen naar een datagedreven organisatie

Het lijkt de normaalste zaak van de wereld dat organisaties datagedreven sturen. Iedereen wil en moet er wat mee. Zonder data hoor je er niet meer bij. Dat horen wij vaak terug in gesprekken met klanten. Als data scientist begrijp ik heel goed waar deze behoefte vandaan komt: data kan organisaties namelijk veel opleveren. Bedrijven zitten vaak op een kluis met goud, maar ze weten niet hoe ze de kluis moeten openen.

Bedrijven zitten vaak op een kluis met goud, maar ze weten niet hoe ze de kluis moeten openen.

Zo hoor ik managers vaak genoeg iets hips roepen, zonder dat ze precies weten wat ze ermee willen bereiken. “Waarom doen wij niets met big data?”, “Kunnen we iets met die nieuwe techniek machine learning?” of “Waarom werkt machine learning niet bij ons? Wij hebben het geprobeerd, maar het werkt helaas niet, dus we zijn ermee gestopt.”

Om een antwoord te kunnen geven op deze vragen moet eerst duidelijk zijn wat we met de termen big data en machine learning bedoelen.

Wat is big data?

Big data is letterlijk een enorme hoeveelheid digitale gegevens die niet meer met reguliere datamanagementsystemen onderhouden kan worden. Tegenwoordig kan er steeds meer en steeds sneller een steeds grotere variatie aan data opgeslagen worden. Zo is steeds meer data van burgers digitaal beschikbaar. Maar het kunnen ook socialmedia-updates zijn, cookies en weblogs, meterstanden, bedrijfsadministratie of gps-locaties van mobiele telefoons. Eigenlijk behoren alle soorten data tot de grote groep big data.

Big data wordt vaak verbonden aan large scale internetorganisaties zoals Netflix en Airbnb. Er wordt vaak voorbijgegaan aan de waarde van de eigen data.

Zelflerend algoritme

Algoritmische modellen uit de machine learning hebben een extra voordeel ten opzichte van traditionele statistiek; ze zijn zelflerend. Het algoritme leert van zijn eigen correcte en incorrecte voorspellingen. Het algoritme is dus net een mens. Het leert steeds meer bij en wordt steeds intelligenter. Dit betekent dat de foutmarge bij elke voorspelling steeds lager wordt en dat de techniek relevante omgevingsfactoren snel kan identificeren en meenemen in een volgende voorspelling.

Garbage in = garbage out

De laatste vraag, “waarom werkt machine learning niet bij ons?” Of zelfs: “we hebben het geprobeerd, maar het werkt helaas niet, dus we zijn ermee gestopt,” doet bij mij alarmbellen rinkelen. Had dit team hun data op orde voordat ze aan de slag gingen met machine learning? De techniek is namelijk zeer geschikt in het vinden van patronen in gedrag, maar hierbij geldt: garbage in = garbage out. De input moet relevant zijn en van voldoende kwaliteit. Als foutieve gegevens het model ingaan, kun je verwachten dat er ook foutieve voorspellingen worden gedaan.

1. Descriptive modelling

De weg naar een datagedreven organisatie start met een ‘simpele’ data-analyse. Wij noemen dit ook wel descriptive modelling. We analyseren de data van binnen naar buiten. Eerst zoeken we alle relevante data bij elkaar. Daarna beoordelen we de data op kwaliteit en kwantiteit: Is de data correct ingevoerd? Hoe zijn de variabelen gevuld? Hoe is de consistentie? Hebben we alles meegenomen? En kunnen we alle databronnen wel met datasleutels aan elkaar koppelen?

We houden altijd een pluk data achter, waarvan we weten dat iemand in het verleden heeft opgezegd of is gebleven. We testen het model door over deze pluk data een voorspelling te doen. Omdat we de uitkomsten (opgezegd of niet) weten, kunnen we kijken hoe het model presteert (voorspelt het veel correct of incorrect). Deze pluk data noemen we een testset.

Verstopte paaseieren

In de analysefase zoeken we ook naar data die een voorspelling onterecht kan beïnvloeden. Zo zag ik een keer bij een klant dat er enquêtedata was meegenomen in een voorspelmodel om opzeggers te voorspellen (churn voorspellen). Het bleek dat deze enquête na het opzeggen was uitgezet, met de vraag waarom iemand opzegt. Als deze variabele is gevuld in de testset, dan triggert het voorspelmodel natuurlijk 100% op opzeggen.

Als je in de praktijk voorspelt wie gaat opzeggen, dan is deze enquête-data niet beschikbaar. Dat wordt immers pas beschikbaar nadat iemand al heeft opgezegd. In de testset is deze data echter wel beschikbaar, omdat je daar data gebruikt vanuit het verleden om te kijken hoe goed het model presteert. Dit beïnvloedt het maken van een business case ten onrechte positief. Het model lijkt immers goed te presteren, maar in de praktijk zal de enquêtedata nooit bekend zijn en is de voorspelling dus waardeloos. Wij noemen dit zelf verstopte paaseieren. Deze moeten eerst allemaal gevonden worden, voordat er een inschatting gemaakt kan worden over de nauwkeurigheid van een voorspellend model.

2. Voorspelmodel

Nadat de data op orde is gaan we door naar de volgende stap: voorspellen. Ik zie vaak simpele voorspelmodellen die gemaakt zijn met oudere regressietechnieken. Waarom zou je tientallen procenten aan voorspelkracht inleveren als je ook kunt voorspellen met machine learning? Ik gebruik vaak neurale netwerken, bayesian inference en random forest of een combinatie van modellen voor het voorspellen. Bij een energieleverancier zagen we het aantal correct geïdentificeerde churners verdubbelen en het aantal foutieve voorspellingen halveren door het regressiemodel (oude statistische technieken) wat zij nu gebruiken te vervangen door een machine learning-model.

Reken maar eens door wat dat extra oplevert! Je behoudt niet alleen meer mensen, maar je benadert ook minder sleepers die door jouw actie misschien alsnog overstappen. Met complexe voorspellingen kun je ontzettend veel winst behalen. De enige keerzijde van machine learning is juist die complexiteit. Anders dan bij traditionele statistische technieken verlies je bij machine learning de verklarende kracht. Dit wil bij de marketeers nog wel eens lastig zijn. Maar waarom zou je verklarende kracht willen, als je daarmee inlevert op voorspelkracht en zo miljoenen omzet misloopt? F*ck the why!

Bij machine learning verlies je de verklarend kracht, maar waarom wil je dat, als dat betekent dat je zo miljoenen misloopt? F*ck the why!

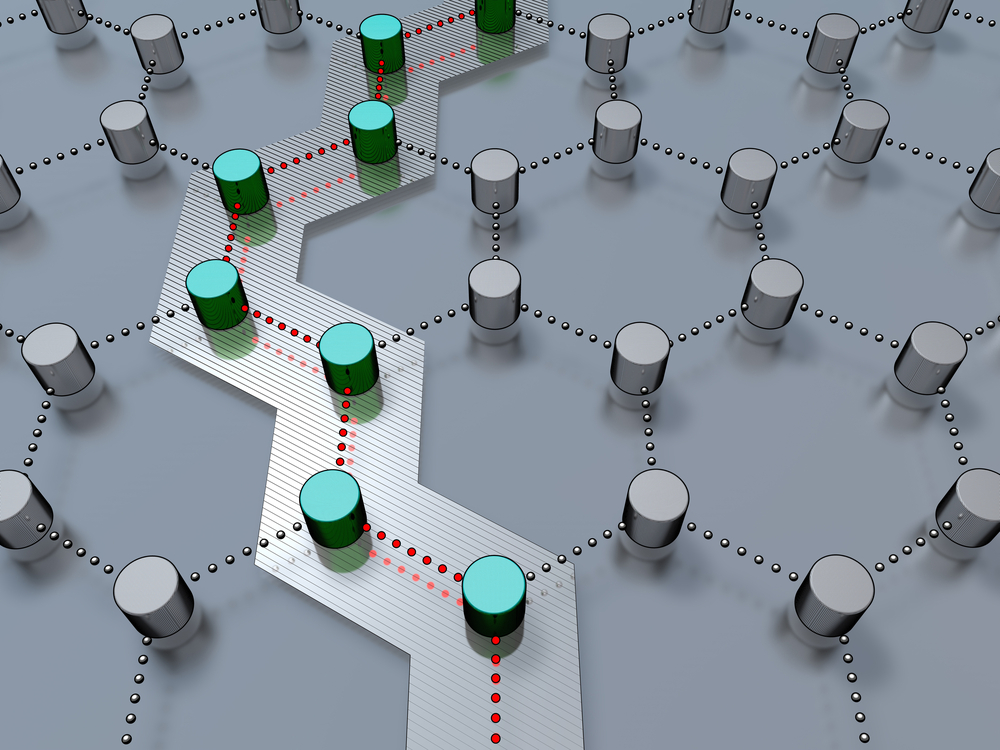

De laatste stap van datagedreven werken is het in verbinding brengen van de brongegevens, model en voorspellingen en deze klaarmaken voor productie.

3. De brug naar prescriptive modelling

Bij descriptive modelling keken we dus naar het verleden, naar de verbanden en de kwaliteit/kwantiteit van de data. Bij predictive modelling gebruiken we de bevindingen en de data om een voorspellend model te ontwikkelen. De technieken lenen zich om te implementeren in de IT- en werkprocessen om zo automatisch het model te leren en nieuwe, realtime, voorspellingen te doen.

De implementatiefase is de brug tussen predictive en prescriptive modelling; bij prescriptive modelling gebruiken we de voorspellingen om geautomatiseerd data driven beslissingen te nemen. Het voorspelmodel wordt geïmplementeerd in de IT- en werkprocessen en voorspelt periodiek. Als je deze stap hebt genomen, heb je de kluis naar het goud weten te openen.

Deze kluis kun je ook verder vullen. Je kunt immers ook voorspellen voor welk aanbod iemand gevoelig is en wanneer je iemand het beste via welk medium kunt benaderen. Wanneer een dergelijk model wordt geïmplementeerd is er sprake van prescriptive modelling. Hiermee kunnen bijvoorbeeld aanbiedingen automatisch gepersonaliseerd worden op inhoud, moment en het juiste medium. Hierdoor vergroot je jouw klantenbestand, de loyaliteit en waarde van je klanten.