AI Act – fase 2: zorg dat je voor 1 augustus 2025 transparant bent

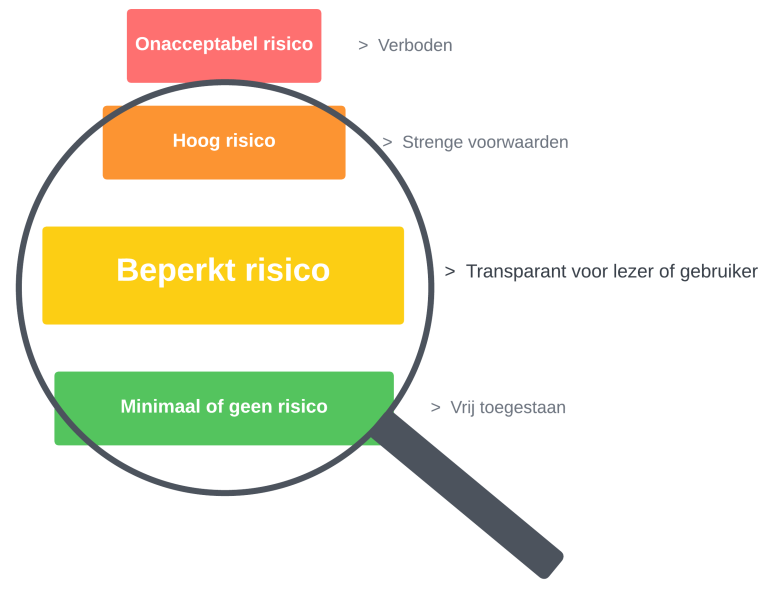

Sinds 1 augustus 2024 voert de EU in fases de AI Act in om burgers tegen nadelige gevolgen van AI te beschermen. In een serie van drie artikelen kijken we naar wat je als AI-gebruiker per fase moet doen. Het eerste artikel beschrijft hoe je onacceptabele en verboden AI uitfaseert. Dit tweede artikel gaat in op hoe je AI uit de categorie ‘beperkt risico’ volgens de AI Act toepast om compliant te zijn.

We duiken meteen de diepte in. En gaan er dus vanuit dat je bekend bent met de risicocategorie-opzet van de AI Act. Is dat niet het geval? Of wil je je kennis even opfrissen? Lees dan het eerste artikel in deze serie of dit eerdere achtergrond-artikel op Frankwatching.

Beperkt risico-AI

Oké, daar gaan we. Per 1 augustus 2025 moet je voor de beperkt risico-AI die je gebruikt, en beschikbaar stelt aan de AI Act, voldoen. Beperkt risico-AI is AI die gebruikers kan misleiden.

Dat kan door zich voor te doen als een persoon zonder dat gebruikers dat weten. Denk hierbij bijvoorbeeld aan een chatbot op een website. Verder kan content die je met general purpose AI, zoals ChatGPT, maakt ook onder beperkt risico-AI vallen zoals we in het eerste artikel zagen.

Dat kan door zich voor te doen als een persoon zonder dat gebruikers dat weten. Denk hierbij bijvoorbeeld aan een chatbot op een website. Verder kan content die je met general purpose AI, zoals ChatGPT, maakt ook onder beperkt risico-AI vallen zoals we in het eerste artikel zagen.

Dus produceer je content met general purpose AI? Gebruikt jouw organisatie chatbots om klanten te helpen bij het oplossen van problemen? Of zet je virtuele assistenten in om bijvoorbeeld marketing-enquêtes uit te voeren? Dan gebruik je beperkt risico-AI en moet je maatregelen treffen om compliant te worden voor de AI Act.

Voorkom boetes

Doe je dat niet, dan loop je het risico op een fikse boete die kan oplopen tot 7,5 miljoen euro of 1 procent van je jaaromzet. Met daarbij opgeteld de imagoschade en alles wat daaruit voortvloeit. Uiteraard wil je dat niet. Via een paar eenvoudige stappen kun je dat gemakkelijk voorkomen.

Maak duidelijk dat gebruikers met AI te maken hebben

De belangrijkste bepaling uit de AI Act voor beperkt risico-AI, is dat lezers weten dat content door of met behulp van AI is gemaakt. En dat gebruikers weten dat ze met AI communiceren. Oftewel: wees transparant over de rol van AI. Meld aan je lezers dat je bepaalde content met behulp van AI hebt gemaakt en aan de gebruiker in een chatsessie dat hij met een chatbot communiceert. Of dat een AI-assistent de vragen in een online enquête stelt.

De stappen

De actie om lezers en gebruikers op AI te attenderen, is onderdeel van het algemene stappenplan voor het toepassen van de AI Act. Met dit plan breng je eerst de eventuele beperkt risico-AI die je gebruikt in kaart via deze stappen:

- Inventariseer alle AI die je gebruikt.

- Bepaal per AI de risicocategorie.

Hierna weet je of en welke beperkt risico-AI je gebruikt. Voer vervolgens deze stappen uit om compliant te worden:

- Leg in bedrijfsrichtlijnen en werkprocedures vast dat je bij het beschikbaar stellen van beperkt risico-AI altijd meldt dat lezers en gebruikers met AI te maken hebben. Verder kun je de verantwoordelijkheid hiervoor bij specifieke medewerkers neerleggen en dit in hun functieomschrijvingen opnemen.

- Voeg de meldingen dat lezers en gebruikers met AI te maken hebben toe aan je op AI gebaseerde content, chatbots, virtuele assistenten en andere beperkt risico-AI die je publiekelijk beschikbaar stelt.

Naast dat je zo via de werkprocedures borgt dat iedereen in je organisatie de bepalingen volgt, dienen de werkprocedures ook als bewijs van je compliancy bij een eventuele controle op naleving van de AI Act.

Voorbeelden van transparantiemeldingen

De melding aan de lezers van je op AI gebaseerde content plaats je bijvoorbeeld bovenaan in een tekst:

Dit artikel is met behulp van AI geschreven.

Of direct onder een afbeelding:

Deze afbeelding is door AI gemaakt.

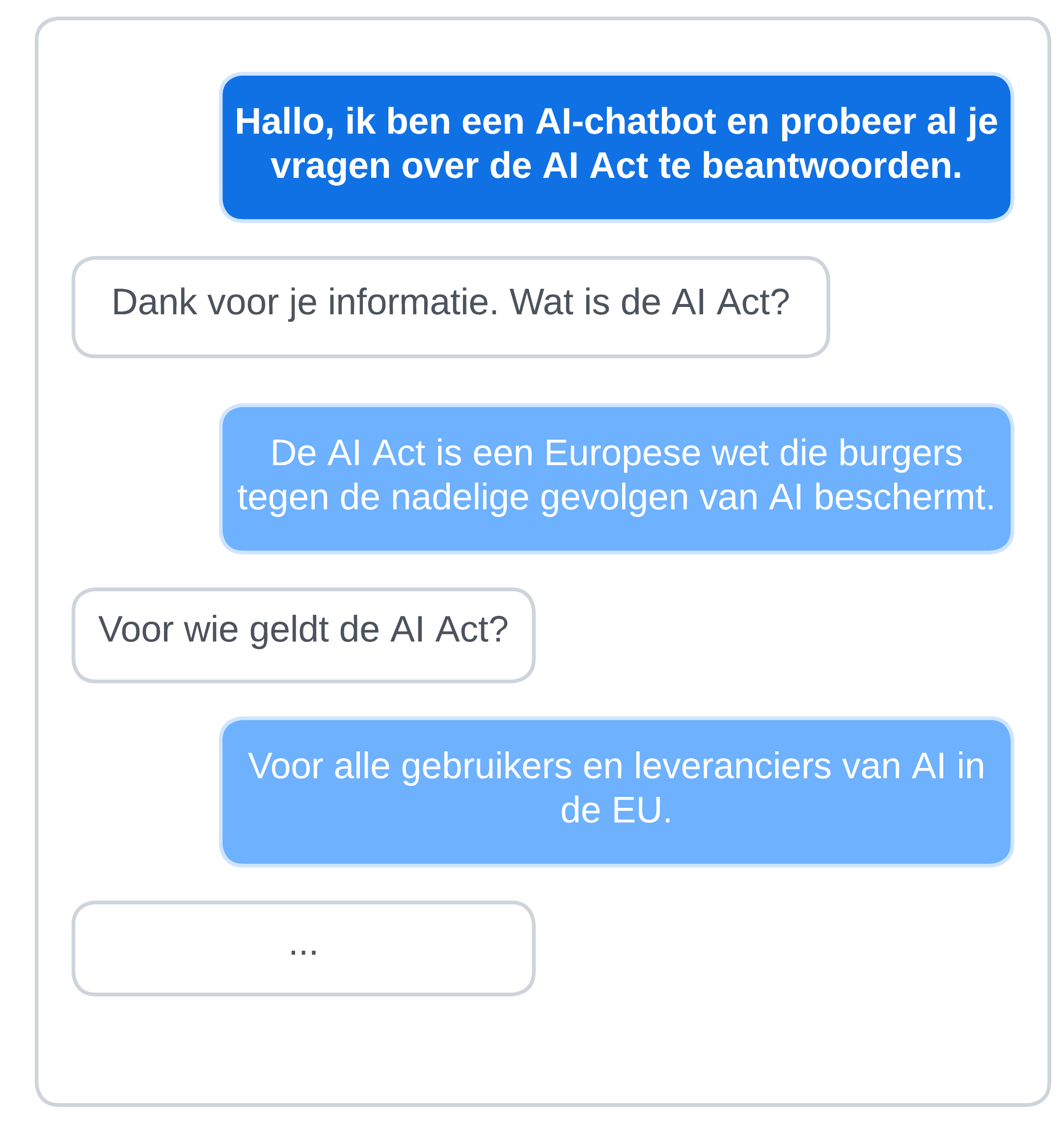

De melding aan de gebruiker in chatbot en virtuele assistenten kan zo eenvoudig zijn als: “Hallo, ik ben een AI-gestuurde assistent en probeer je te helpen bij je vraag.” Zorg er wel voor dat een sessie of enquête met de melding begint, want dan weten gebruikers direct dat men met AI communiceert.

Transparantie is win-win

Zoals gezegd moet je per 1 augustus 2025 voor beperkt risico-AI aan de AI Act bepalingen voldoen. Je hebt dus nog even de tijd, maar voor een goede omgang met je lezers en gebruikers is het wel zo netjes om zo snel mogelijk transparant te zijn over de inzet van AI. Dit vergroot het vertrouwen in je organisatie en dan ben je al meteen compliant op dit onderdeel van de AI Act.

ChatGPT

ChatGPT